Robots.txt คืออะไร ? สิ่งสำคัญที่คนทำ SEO ต้องรู้ !!

ความสำคัญของการทำ SEO ไม่ได้มีแค่วางโครงสร้างเว็บไซต์ให้รองรับการติดอันดับบน Google แต่การทำ SEO นั้นหลัก ๆ แบ่งได้เป็น 3 ประเด็นใหญ่ ๆ ก็คือ การปรับ On-Page และ Off-Page รวมไปถึงเรื่อง Technical ที่มีส่วนในการช่วยให้เว็บไซต์ของเรานั้นมีโอกาสที่จะติดอันดับมากขึ้น สามารถอ่านเพิ่มเติม : SEO คือ อะไร? วิธีการทำ SEO ให้ปัง อยากให้เว็บไซต์ติดอันดับบน Google ต้องรู้

วันนี้เรามีเทคนิคเกี่ยวกับการปรับ SEO ในส่วนของ Technical คือการปรับ Robots.txt มาฝากทุกคนกันค่ะ เพียงแค่ปรับจุดนี้เพียงเล็กน้อยก็สามารถทำให้เว็บไซต์ของเรามีผลลัพธ์ SEO ที่ดีขึ้นได้

“Web Performance ดีขึ้นแค่ปรับ Robots.txt”

Robots.txt คืออะไร?

Robots.txt คือ ไฟล์สคริปต์ที่อยู่ใน Root Directory ของเว็บไซต์ สร้างขึ้นเพื่อสั่งให้บอทของ Search Engine รู้ว่าเว็บไซต์หน้าไหนที่ต้องการให้มาเก็บข้อมูล (Indexing) และหน้าไหนที่ไม่ต้องการให้เก็บข้อมูล (Crawling) ซึ่ง Robots.txt เปรียบเสมือนป้ายกำกับ และป้ายห้ามที่บอกบอทว่าหน้าไหนทำอะไรได้ และหน้าไหนทำอะไรไม่ได้

ความสำคัญของ Robots.txt ที่มีต่อ SEO

โดยปกติแล้วการทำ SEO คือ การทำเว็บไซต์ให้ติดอันดับต้น ๆ ของ Google แต่หากหน้าเพจบางหน้าที่ไม่ต้องการให้ Search Engine นำไปแสดง Robots.txt สามารถช่วยป้องกันไม่ให้บอทเข้ามาค้นหา และจัดทำ Index เอาหน้าเพจที่เราไม่ต้องการไปแสดงเป็นผลลัพธ์การค้นหา

- ป้องกันการเข้าถึงหน้าที่ซ้ำซ้อน และหน้าที่ไม่ต้องการให้แสดง : Robots.txt ช่วยบล็อกไม่ให้บอทเข้ามาค้นหาหน้าที่ซ้ำซ้อน หน้าที่ไม่ได้ถูกเผยแพร่ หรือหน้าที่ไม่ควรแสดงผลบนการค้นหา เช่น หน้าเข้าสู่ระบบ หรือหน้าสมาชิกที่ไม่จำเป็นต้องแสดง

- เพิ่มประสิทธิภาพการใช้งาน Crawl Budget เว็บไซต์ : Crawl Budget คือ จำนวนหน้าที่เครื่องมือค้นหาสามารถค้นหาได้ในระยะเวลาหนึ่ง Robots.txt จะช่วยลดการเข้าถึงหน้าที่ไม่จำเป็น ทำให้บอทเก็บข้อมูลได้ดีขึ้น มีความเจาะจงมากขึ้น ส่งผลให้เว็บไซต์มีโอกาสถูกจัดอันดับในผลการค้นหาได้มากขึ้น และได้ Web Performance ที่ดีขึ้น

- ป้องกันบอทไม่ให้ทำ Index ไฟล์บนเว็บไซต์ : บางครั้งเราต้องการเก็บรักษาข้อมูลเฉพาะบางส่วน และไม่ต้องการให้เครื่องมือค้นหาเข้าถึง เช่น ไฟล์ PDF วิดีโอ หรือรูปภาพ เราสามารถบล็อกบอทไม่ให้เข้าถึงเนื้อหาเหล่านี้ได้ด้วย Robots.txt

สคริปต์และคำสั่ง Robots.txt ที่ชาว SEO ไม่รู้ไม่ได้

สคริปต์ Robots.txt คือ ไฟล์ที่ใช้ในการบอก Search Engine Robots ว่าส่วนไหนของเว็บไซต์ควรถูกค้นหา และส่วนไหนไม่ควรถูกค้นหา โดยหลัก ๆ สคริปต์สำคัญ ๆ ที่ชาว SEO ต้องรู้มีดังนี้

- User-Agent คือ คำสั่งที่ใช้สื่อสารกับบอทโดยตรง ว่า User-agent ต้องการใช้ Robots.txt อย่างไร โดยส่วนใหญ่จะใช้คำสั่ง “User-agent: *” ซึ่งแสดงว่าทุก Search Engine Robots ต้องการใช้ไฟล์ Robots.txt

- Disallow คือ คำสั่งที่ใช้เพื่อบอกบอทว่า URLs ที่มีคำสั่งนี้ไม่ควรถูกเข้าถึง หรือ Crawling โดยสามารถระบุเส้นทางหรือเริ่มต้น URL ที่ต้องการป้องกันได้

- Allow คือ คำสั่งที่ใช้บอก Search Engine Robots ว่าส่วนไหนของเว็บไซต์ควรถูกค้นหา โดยใช้เครื่องหมาย “/” เพื่อระบุหน้าเว็บไซต์หรือโฟลเดอร์ที่ต้องการให้ค้นหา

- Sitemap คือ คำสั่งที่ใช้บอก Search Engine Robots ว่ามีไฟล์ Sitemap อยู่ที่ไหน เพื่อช่วยให้ Search Engine Robots สามารถเข้าถึงและดาวน์โหลดไฟล์ Sitemap ได้อย่างง่ายดาย

ตัวอย่างการเขียนคำสั่ง Script ในไฟล์ Robots.txt

มาถึงตอนนี้หลาย ๆ คนคงจะรู้จัก Robots.txt กันมากขึ้นแล้ว มาดูตัวอย่างการใช้งาน Robots.txt ที่ถูกต้อง กันว่าพวกเราชาว SEO จะใช้ Script แต่ละไฟล์ยังไงให้ได้ผลลัพธ์ดีที่สุด

ตัวอย่างที่ 1 : คำสั่งไม่อนุญาตให้ Search Engine ตัวไหนก็ตามเข้ามาเก็บข้อมูลทั้งเว็บไซต์

User-agent:*

Disallow: /

ตัวอย่างที่ 2 : คำสั่งไม่อนุญาตให้ Search Engine ของ Google เข้าถึงโฟลเดอร์ ชื่อ private

User-agent: Googlebot

Disallow: /private/

ตัวอย่างที่ 3 : คำสั่งอนุญาตให้ Search Engine เก็บข้อมูลทุกส่วนของเว็บไซต์

User-agent:*

Allow: /

ตัวอย่างที่ 4 : อนุญาตให้ Search Engine ทั้งหมด ยกเว้นตัวใดตัวหนึ่ง

User-agent: UnnecessarybotDisallow: /

User-agent: *Allow:

ตัวอย่างที่ 5 : ไม่อนุญาตให้เก็บข้อมูลไฟล์บางประเภท เช่น ไฟล์ .gif

User-agent: GooglebotDisallow:

/*.gif

จะเกิดอะไรขึ้นหากเว็บไซต์ไม่มี Robots.txt

การที่เว็บไซต์ไม่มีการติดตั้ง Robots.txt ก็เปรียบเสมือนถนนไม่มีป้ายบอกทาง Search Engine จะไม่รู้เลยว่าหน้าเพจไหนควรเก็บข้อมูลเพื่อนำไปจัดอันดับ หรือหน้าเพจไหนไม่ควรมาเก็บข้อมูล

Search Engine จะถือว่าได้รับอนุญาตให้รวบรวมข้อมูลและจัดทำดัชนีเว็บไซต์ทั้งหมด ข้อเสียของเว็บไซต์ถ้าหากไม่มีการติดตั้ง Robot.txt ที่เรารวบรวมมา มีอะไรบ้างมาดูเลย

- เว็บไซต์ขาดการควบคุมในการรวบรวมข้อมูล

เว็บไซต์ที่ไม่มีไฟล์ Robot.txt จะไม่สามารถบอกให้ Search Engine Robots รู้ว่าส่วนใดของเว็บไซต์รวบรวมข้อมูลที่สามารถเข้าถึงได้ หากไม่มี Robot.txt อาจะทำให้ข้อมูลที่ละเอียดอ่อน หรือซ้ำกันถูกจัดทำ Index และนำไปแสดงผลบนหน้า Google - ทำ Index หน้าผู้ดูแลระบบที่ไม่ต้องการ

เว็บไซต์จะมีหน้าดูแลระบบ หรือหน้าสำหรับเข้าสู่ระบบซึ่งหน้าพวกนี้ไม่ได้มีไว้สำหรับแสดงผล ซึ่งถ้าหากไม่มี Robot.txt เครื่องมือค้นหาก็สามารถทำ Index หน้าเหล่านี้ได้ อาจเกิดความเสี่ยงในเรื่องของความปลอดภัย และการพยายามเข้าถึงโดยไม่ได้รับอนุญาต - เว็บไซต์โหลดช้า

หาก Search Engine Robots สามารถเข้าถึงทุกส่วนของเว็บไซต์โดยที่ไม่มีข้อกำจัด ก็อาจจะส่งผลให้เว็บไซต์โหลดเซิร์ฟเวอร์ที่สูงได้ ซึ่งก็จะส่งผลไปถึงประสิทธิภาพของเว็บไซต์ที่จะโหลดหน้าเว็บนานขึ้น ทำให้ผู้ใช้ได้รับประสบการณ์ที่ไม่ดี - เกิดความยุ่งยากในการจัดการเนื้อหาที่ซ้ำกัน

ไฟล์ Robot.txt จะคอยเป็นป้ายบอกทางให้กับ Search Engine Robots รู้ว่าข้อมูลไหนควรนำไปแสดง และไม่ควรนำไปแสดง ซึ่งถ้าเว็บไซต์ไม่มี Robot.txt ปัญหาที่เนื้อหาซ้ำกันอาจเกิดขึ้นได้ Bot อาจทำ Index ที่เป็นเนื้อหาเดียวกันหลายเวอร์ชัน ส่งผลให้อันดับของเว็บไซต์ตกลง - SEO ที่ไม่มีประสิทธิภาพ

เว็บไซต์ที่ต้องการเพิ่มประสิทธิภาพของ SEO แต่ดันไม่มี Robot.txt ก็อาจจะไปไม่ถึงเป้าหมาย การจัดทำ Index ที่ไม่สามารถควบคุมได้นำไปสู่กลยุทธ์ SEO ที่ไม่มีประสิทธิภาพ เพราะเนื้อหาสาระสำคัญอาจถูกปิดกั้นจากหน้าที่ไม่ควรนำมาแสดงผล

อ่านเพิ่มเติม : เคล็ดลับการทำ SEO ให้เว็บไซต์ติดหน้าแรก Google ฟรี

ซึ่งการไม่มี Robot.txt มีข้อเสียมากกว่าข้อดี ไม่ว่าจะเป็นความเสี่ยงในเรื่องของความปลอดภัย ไม่สามารถควบคุมการเข้าถึงข้อมูลได้ และการทำ SEO ที่ไม่มีประสิทธิภาพ ดังนั้น เราควรเลือกใช้คำสั่ง Robot.txt ที่สอดคล้องกับเป้าหมาย และกลยุทธ์การจัดการเนื้อหาบนหน้าเว็บไซต์นั้น ๆ ด้วย

วิธีติดตั้งสคริปต์ Robots.txt สำหรับลูกค้า MakeWebEasy

ขั้นตอนที่ 1 เข้าสู่ระบบหลังบ้านของ MakeWebEasy

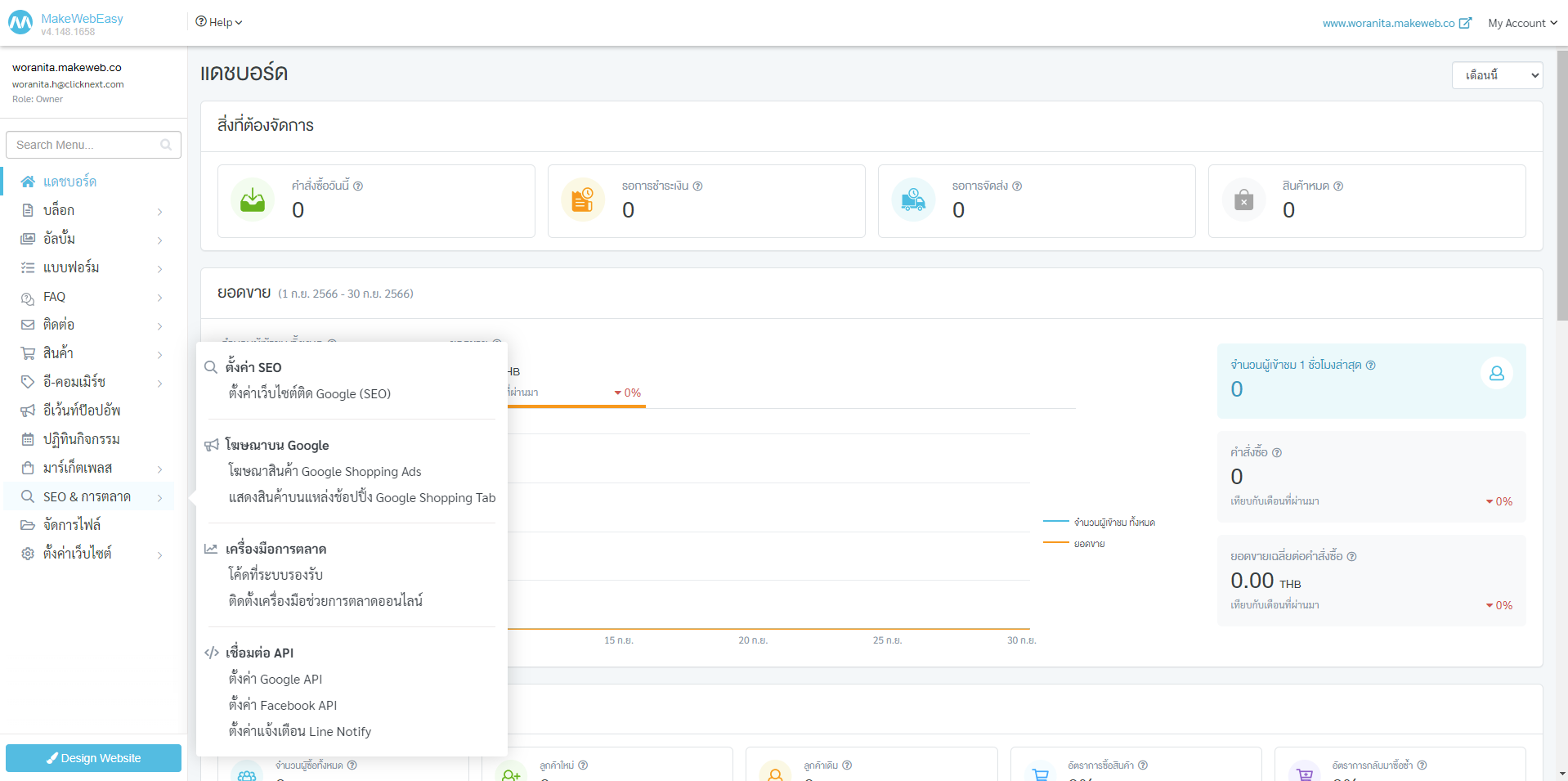

ขั้นตอนที่ 2 ไปที่เมนู SEO & การตลาด เลือกเมนู ตั้งค่าเว็บไซต์ติด Google (SEO)

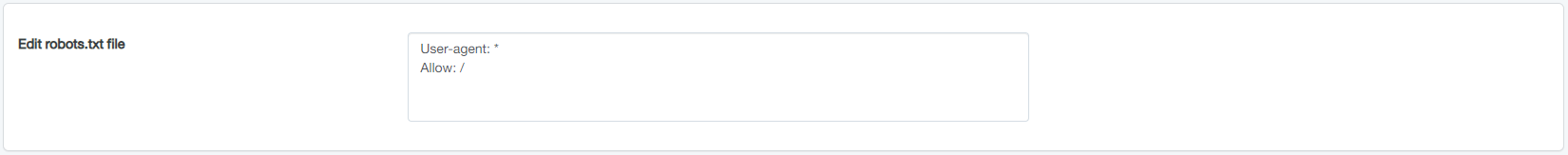

ขั้นตอนที่ 3 ติดตั้ง Script Robots.txt ได้ที่ Edit robots.txt file จากนั้นกดบันทึก

ข้อควรระวังในการทำ Robots.txt

ข้อที่ควรระมัดระวังสำหรับชาว SEO ที่ต้องการจะทำ Robots.txt คือ การเขียน Script ไม่ถูกต้อง เนื่องจากไฟล์ Robots.txt เป็นไฟล์แรกที่บอทจะเข้ามาอ่าน ถ้าหากเขียนไม่ถูกต้อง หรือใช้คำสั่งผิด ก็จะส่งผลต่อการเก็บข้อมูล รวมไปถึงการจัดทำ Index ของเว็บไซต์ทั้งหมด เช่น ไม่มีการเก็บข้อมูลเกิดขึ้น หน้าเพจที่สำคัญ หรือเว็บไซต์ที่เราต้องการให้ติดอันดับก็จะไม่เกิดขึ้นเลย

เราสามารถตรวจสอบความถูกต้องของ Script ได้ที่ Google Search Console ด้วยเครื่องมือ Robots Testing Tool หากมีข้อผิดพลาดหรือน่าสงสัย Robot Testing Tool จะเตือนจำนวน Errors และ Warnings ให้ แต่ถ้าไม่มีข้อผิดพลาด จะขึ้นเป็น 0

แต่วิธีนี้จะใช้ได้ก็ต่อเมื่อเว็บไซต์ของเรามีการเชื่อมต่อ Google Search Console ไว้อยู่แล้ว

สรุปความสำคัญของ Robots.txt ในการทำ SEO

Robots.txt เป็นเครื่องมือสำคัญในการจัดการ และปรับปรุงการทำ SEO ของเว็บไซต์เพื่อให้ได้ผลการค้นหาที่ดี และเพิ่มโอกาสในการติดอันดับบน Google รวมไปถึงช่องทางอื่น ๆ อีกด้วย

การใช้งาน Robots.txt ที่ถูกต้องจะช่วยลดโอกาสในการเข้าถึงเนื้อหาที่ไม่ต้องการให้แสดงผล และเพิ่มโอกาสในการได้รับการจัดอันดับ Search Engine Result Pages (SERP) ซึ่งเป็นสิ่งสำคัญในการทำ SEO

สร้างโอกาสให้เว็บไซต์ของคุณติดหน้าแรก Google เพิ่มผู้ชม และยอดขายบนเว็บไซต์ด้วยบริการ SEO ของเราให้ธุรกิจคุณเหนือกว่าคู่แข่ง บริการรับทำ SEO จาก MakeWebEasy